Aktivität 21 – der Turing-Test

Gespräche mit Computern – der Turing-Test

Diese Aktivität zielt darauf ab, Diskussionen über die Frage anzuregen, ob Computer „Intelligenz“ zeigen können oder in Zukunft wahrscheinlich können werden. Basierend auf der Ansicht eines wegweisenden Informatikers, wie man künstliche Intelligenz erkennt: Wenn sie jemals auftaucht, vermittelt sie etwas von dem, was derzeit machbar ist und wie leicht es ist, durch sorgfältig ausgewählte Demonstrationen von „Intelligenz“ in die Irre geführt zu werden.

- Befragung

- Logisches Denken

- 7+

Worum geht es in dieser Aktivität?

Seit Jahrhunderten streiten sich PhilosophInnen darüber, ob eine Maschine menschliche Intelligenz simulieren könnte, und umgekehrt, ob das menschliche Gehirn nichts anderes ist als eine Maschine, die ein besseres Computerprogramm ausführt. Diese Frage hat die Menschen stark geteilt. Manche finden die Idee absurd, wahnsinnig oder sogar blasphemisch, während andere glauben, dass künstliche Intelligenz unvermeidlich ist und wir letztendlich Maschinen entwickeln werden, die genauso intelligent sind wie wir. (Wie zahlreiche Science-Fiction-Autoren gezeigt haben, werden Maschinen, selbst wenn sie letztendlich unsere eigene Intelligenz übertreffen, in der Lage sein, sogar klügere Maschinen zu konstruieren.) Künstliche Intelligenz (KI)-ForscherInnen wurden dafür kritisiert, dass sie ihre hochgesteckten Ziele dazu nutzen, Forschungsgelder von Regierungen zu bekommen um autonome Kriegsmaschinen zu bauen, während die ForscherInnen selbst die Proteste als technikfeindliche Gegenreaktion zurückweisen und eindeutig auf die Vorteile für die Gesellschaft hinweisen, wenn es nur ein bisschen mehr Intelligenz gäbe. Eine ausgewogenere Sichtweise ist, dass künstliche Intelligenz weder absurd noch unvermeidlich ist: Während keines der gegenwärtigen Computerprogramme „Intelligenz“ in einem weiten Sinne aufweist, ist es eine experimentelle, noch nicht beantwortete Frage, ob sie dazu auch in der Lage sind.

Die KI-Debatte hängt von der Definition von Intelligenz ab. Viele Definitionen wurden vorgeschlagen und diskutiert. Ein interessanter Ansatz zur Schaffung von Intelligenz wurde in den späten 1940er Jahren von Alan Turing, einem bedeutenden britischen Mathematiker, Kriegsgegner und Langstreckenläufer, als eine Art „Gedankenexperiment“ vorgeschlagen. Turings Ansatz war operativ - anstatt Intelligenz zu definieren, beschrieb er eine Situation, in der ein Computer sie demonstrieren konnte. Sein Szenario war ähnlich der oben beschriebenen Aktivität, die Essenz bestand darin einen Fragesteller zu haben, der sowohl mit einer Person als auch mit einem Computer über eine Fernschreiberverbindung (die neueste Technologie der 1940er Jahre!) interagierte. Wenn der Fragesteller nicht zuverlässig voneinander unterscheiden konnte, hätte der Computer Turings Test für Intelligenz bestanden. Die Verwendung eines Fernschreibers vermied das Problem, dass der Computer durch physische Eigenschaften oder Tonfall verraten wurde. Man kann sich vorstellen, die Übung so zu erweitern, dass die Maschine eine Person in Aussehen, Klang, Berührung, vielleicht sogar Geruch nachahmen muss - aber diese physischen Attribute scheinen für die Intelligenz kaum relevant zu sein.

Turings Originaltest war ein bisschen anders als unserer. Er schlug als vorläufige Übung ein Szenario vor, in dem ein Mann und eine Frau verhört wurden und der Fragesteller ihre Geschlechter bestimmen musste. Das Ziel des Mannes bestand darin, den Fragenden davon zu überzeugen, dass er die Frau war, und die Frau sollte den Fragenden davon überzeugen, dass sie sie selbst war. Dann stellte sich Turing einen Computer vor - da dies nur als Gedankenexperiment vorgeschlagen wurde - der eine der Parteien ersetzte, um zu sehen, ob er bei diesem „Nachahmungsspiel“ genauso erfolgreich sein konnte wie ein Mensch. Wir haben das Setup für diese Klassenaktivität geändert, weil die Art von Fragen, die die SchülerInnen stellen könnten um das Geschlecht zu bestimmen, wahrscheinlich nicht angemessen wäre. Außerdem fördert die Übung die klischeehafte Zuordnung der Geschlechterrollen - ganz zu schweigen von Irreführungen.

Intelligenz nachzuahmen ist eine schwierige Aufgabe. Wenn die Rollen vertauscht würden und eine Person sich als Computer ausgeben wollte, würde sie das sicher nicht tun können: Sie würde durch ihre langsame (und wahrscheinlich ungenaue) Antwort auf Fragen wie „Was ist 123456 × 789012?“ verraten.

Es ist jedoch überraschend einfach für einen Computer, eine ‘dünne Schicht’ an Konversationsfähigkeit zu erlangen. Das berühmte Programm Eliza (bereits erwähnt), das in den frühen 60er Jahren entwickelt wurde, simulierte einen nicht-direktiven Psychotherapeuten im Dialog mit dem Benutzer. Unten ist ein Beispiel für eine Konversation mit diesem System. Etwas, das sich einer natürlichen Konversation nähert, kann von Maschinen erzeugt werden, wie z.B.:

• Erzeugen von vorgefertigten Antworten (z. B. Kannst du da an ein bestimmtes Beispiel denken? als Antwort auf etwas, das anfängt wie Sie sind immer ...; Es tut mir leid zu hören, dass ... als Antwort auf Er sagt ...);

• Aussagen des Nutzers widerspiegeln (z. B. Dein Freund hat dich hierher kommen lassen als Antwort auf Mein Freund hat mich hierher kommen lassen);

• Schlüsselworte erkennen (Erzähle mir mehr über deine Familie als Antwort auf ... Mutter ...);

• einige Standardausdrücke (Was würde es für dich bedeuten, wenn ...);

• Dinge, die aus früheren Teilen der Konversation übernommen wurden (Hat das etwas damit zu tun, dass ...).

Natürlich bedeutet dies nicht, dass der Turing-Test bestanden wurde, da die Person keine Fragen stellt, um festzustellen, ob der Befragte eine Maschine ist oder nicht: Wenn es so wäre, würde es nicht lange dauern, bis es geklärt worden wäre.

Person: Menschen sind alle gleich.

Computer: Auf welche Weise?

Person: Sie nerven uns immer wegen irgendwas.

Computer: Kannst du an ein bestimmtes Beispiel denken?

Person: Nun, mein Freund hat mich hierher kommen lassen.

Computer: Dein Freund hat dich hierher kommen lassen.

Person: Er sagt, ich bin die meiste Zeit deprimiert.

Computer: Es tut mir leid zu hören, dass du deprimiert bist.

Person: Das stimmt. Ich bin unglücklich.

Computer: Denkst du, dass dein Kommen zu mir dir helfen wird,

nicht unglücklich zu sein?

Person: Ich brauche Hilfe, das scheint mir sicher.

Computer: Was würde es für dich bedeuten, wenn du Hilfe bekommst?

Person: Vielleicht könnte ich lernen, mit meiner Mutter auszukommen.

Computer: Erzähl mir mehr über deine Familie. …

Computer: Was fällt dir sonst noch ein, wenn du an deinen Vater denkst?

Person: Tyrann!

Computer: Hat das etwas damit zu tun, dass dein Freund dir gesagt hat, dass du hierher kommen sollst? …

Ein weithin zitierter Vorfall, der vielleicht apokryph ist, aber nun in der Geschichte der künstlichen Intelligenz zu finden ist, ereignete sich als ein Vizepräsident (VP) für Computerverkäufe angeblich auf ein Terminal stieß, das normalerweise direkt mit dem Haus einer bestimmten Person verbunden war, aber diesmal das „Psychotherapeuten“-Programm ausführte. Das Gespräch zeigt, was passiert ist. Weil der Vizepräsident offensichtlich Kontakt aufnehmen konnte, ist es klar, dass die Situation ihn prädisponiert

hat zu glauben, dass er mit einer Person sprach. Hätte er etwas anderes vermutet, hätte er es bald bemerkt!

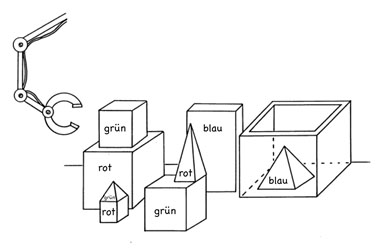

Ein anderes System, das in der Lage zu sein scheint, intelligente Gespräche zu führen, ist ein Programm namens „SHRDLU“, das in den späten 60er Jahren entwickelt wurde und die Anweisungen annahm, Blöcke auf einem Tisch zu versetzen. Tatsächlich wurden die Blöcke und der Tisch simuliert und in Form eines Bildes auf einem Computerbildschirm dargestellt, obwohl es nicht zu schwierig gewesen wäre, die Dinge von einem echten Roboter durchführen zu lassen (zumindest im Prinzip). Das Bild zeigt die Mikrowelt des Roboters.

VP: Denkst du, dass ich heute morgen den Computer benutzen kann?

Terminal: Warum fragst du?

VP : Ich könnte vielleicht zusätzliche Telekommunikationsverkäufe machen.

Terminal : Warum bist du dir nicht sicher?

VP : Meine potenziellen Kunden haben noch nie eine Vorführung des Systems gesehen.

Terminal : Bedeutet das sehr viel für dich?

VP : Natürlich tut es das.

Terminal : Sie scheinen sehr positiv darüber zu sein.

VP : Das ist lächerlich.

Terminal : Was meinst du damit?

VP : Gibt es einen Grund, warum ich den Computer jetzt nicht benutzen kann?

Terminal : Erzähl mir mehr über deine potenziellen Kunden.

VP : Bitte ruf mich an unter 491-1850

VP vergisst, einen Punkt einzugeben ... der Computer antwortet nicht ... VP wird so wütend, dass er die Person zu Hause anruft.

VP: Warum bist du so rotzfrech zu mir?

Person: Was meinst du damit, warum ich rotzfrech zu dir bin?

SHRDLU konnte überraschend fließende Gespräche führen, wie im folgenden Dialog gezeigt wird. Dies zeigt unter anderem, wie es Befehlen gehorchen, Anweisungen vereindeutigen, den Bezug von Pronomen erarbeiten und neue Begriffe („Kirchturm“) verstehen kann.

Person: Hebe einen großen roten Block auf.

Roboter: Ok.

Das System antwortet mit “OK”, wenn es einen Befehl ausführt. Um den roten Block aufzuheben, musste er ihn abräumen, indem er einen Platz für den grünen Block fand und den grünen Block wegbewegte

Person: Fasse die Pyramide.

Roboter: Ich weiß nicht, welche Pyramide du meinst.

Es gibt drei Pyramiden in der Szene, also macht das Programm nichts.

Person: Finde einen Block, der größer ist als der, den du in der Hand hältst, und lege ihn in die Schachtel.

Das System muss herausfinden, was mit “Eins” und “Es” gemeint ist, und anhand der Schlussfolgerung entscheiden, welchen Block es hält.

Roboter: Mit “Es” nehme ich an, du meinst den Block, der größer ist als der, den ich halte.

Gedruckt um uns auf dem Laufenden zu halten.

Roboter: Ok.

Die Hand muss den roten Block ablegen, um den größeren blauen Block aufzunehmen.

Person: Was enthält die Box?

Roboter: Die blaue Pyramide und den blauen Block.

Person: Wovon wird die Pyramide abgestützt?

Vorher antwortete das System auf “die Pyramide”, indem es sagte: “Ich weiß nicht, welche Pyramide du meinst.” Jetzt weiß es, dass es das eben Erwähnte bedeuten muss.

Roboter: Die Box.

Person: Hat ein Kirchturm ...

Roboter: Entschuldigung, ich kenne das Wort „Kirchturm“ nicht.

Das System unterbricht sofort, wenn es ein Wort findet, das es nicht interpretieren kann.

Person: Ein „Kirchturm“ ist ein Stapel, der zwei grüne Würfel und eine Pyramide enthält.

Die Anführungszeichen zeigen an, dass wir ein neues Wort definieren.

Roboter: Ich verstehe.

Person: Gibts dort Kirchtürme?

Roboter: Nein.

Die neue Definition dient zur Beschreibung, um Kirchtürme zu erkennen.

Person: Baue einen.

Roboter: Ok.

Die in der Definition gegebene Beschreibung reicht aus, um einen Plan zum Aufbau neuer Objekte, sowie deren Erkennung abzuleiten. Das Wort “eins” bedeutet “ein Kirchturm”, und der Plan wird ausgeführt.

Das System ist jedoch sehr zerbrechlich und die Illusion, die es erzeugt, wird leicht zerstört.

Hier ist eine Fortsetzung der Konversation - die nicht wirklich vom Programm generiert wurde, aber sich bestimmt so hätte ergeben können. Obwohl es möglich war, den neuen Begriff „Kirchturm“ im letzten Gespräch zu definieren, kann nur eine sehr begrenzte Art von Begriffen beschrieben werden, da der Roboter eine extrem eingeschränkte „Intelligenz“ hat.

Person: Tausche den großen roten Block gegen eine Wasserpistole aus.

Roboter: Entschuldigung, ich kenne das Wort „Tausche“ nicht.

Person: Ein „Tausch“ ist ein freier Wechsel von Eigentum.

Roboter: Entschuldigung, ich kenne das Wort „frei“ nicht.

Person: Eine „freie“ Handlung wird freiwillig und ohne Zwang ausgeführt.

Roboter: Tut mir leid, ich kenne das Wort „Handlung“ nicht.

Person: „Handlungen“ sind das, was Leute absichtlich und nicht zufällig tun.

Roboter: Entschuldigung, ich kenne das Wort „Leute“ nicht.

Person: Entschuldigung, ich dachte du wärst schlauer als du bist.

Roboter: Entschuldigung, ich kenne das Wort „Entschuldigung“ nicht.

Letzten Endes muss der Roboter zugeben, dass er nicht einmal die Wörter versteht, die er selbst benutzt (Entschuldigung, ich kenne das Wort „Entschuldigung“ nicht)!

Betrachte nun eine alternative, völlig imaginäre Fortsetzung der Konversation, die möglicherweise von einem Schüler oder einer Schülerin erstellt wurde. Obwohl winzig, zeigt dieses Fragment eine Fülle von Weltwissen.

Person: Tausche den großen roten Block gegen eine Wasserpistole aus.

Roboter: Ich habe schon eine Wasserpistole, aber ich gebe dir zwei Blöcke und eine Pyramide für deinen schleimigen alten Frosch.

• Der „Roboter“ weiß, dass eine Wasserpistole weniger wertvoll ist, wenn man bereits eine besitzt.

• Außerdem erwartet er, dass die Person das auch weiß, da er sich nicht darum bemüht zu erklären, dass dies ein Grund für die Ablehnung des Angebots ist.

• Dennoch sieht er, dass die Person unbedingt einen Block will und bereit ist, sich von etwas Wichtigem zu trennen.

• Er sieht auch ein, dass - im Gegensatz zu Wasserpistolen - Blöcke in der Quantität wertvoller sind.

• Er versucht, die Person zu besänftigen, indem er den Frosch erniedrigt.

• Das bedeutet, dass er bereit ist zu feilschen.

Sicher ist dieser Grad an Kunstfertigkeit noch weit weg von den heutigen Computern!

Die Geschichte unten wurde von einem anderen Computerprogramm (Ende der 80er Jahre) generiert. Obwohl es durch seine Spärlichkeit und Kürze sofort als computergeneriert erkannt wird, ist es nicht schwer sich vorzustellen, wie es durch das Hinzufügen aller Arten von Details verfeinert werden könnte.

Interessant sind nicht die oberflächlichen Aspekte der Geschichte, sondern die Handlung, die sie verkörpert. Diese ist zwar weit entfernt von jeder vom Menschen erzeugten Handlung, aber sie scheint einige menschliche Konfliktelemente zu beinhalten. Heutzutage gibt es eine Reihe von Systemen zum automatischen Erstellen von Stories (Geschichten), obwohl die Herausforderung bei der Bewertung darin besteht zu bestimmen, wie viel Material nur Standardmuster mit zu füllenden Lücken ist, und wie umfangreich die Handlung ist, die wie oben kreativ aufgebaut wurde.

Es war einmal eine Küstenseeschwalbe namens Truman. Truman war obdachlos. Truman brauchte ein Nest. Er flog zum Ufer. Truman suchte nach einigen Zweigen. Truman fand keine Zweige. Er flog in die Tundra. Er traf einen Eisbären namens Horace. Truman fragte Horace, wo es Zweige gäbe. Horace verbarg die Zweige. Horace erzählte Truman, dass einige Zweige auf dem Eisberg waren. Truman flog zum Eisberg. Er suchte nach einigen Zweigen. Er fand keine Zweige. Horace suchte nach etwas Fleisch. Er hat etwas Fleisch gefunden. Er aß Truman. Truman ist gestorben.

Es gibt einen jährlichen Wettbewerb für den Loebner-Preis, bei dem Computerprogramme darum kämpfen, den Turing-Test zu bestehen, indem sie sich bei der Jury als Mensch vorgeben. Seit 2012 hat noch kein Computer die Gold- oder Silberpreise gewonnen, bei denen die Jurymitglieder ständig getäuscht worden sind, aber jedes Jahr wird ein Bronze-Preis für das ‘menschlichste’ der bewerteten Programme vergeben. Im ersten Jahr des Wettbewerbs (1991) gelang es einem Programm einen Bronze-Preis zu gewinnen, der unter anderem Tippfehler menschlich erscheinen ließ!

Es wurde kein künstliches Intelligenzsystem geschaffen, das den Turing-Test fast vollständig besteht. Selbst wenn man dies täte, haben viele PhilosophInnen behauptet, dass der Test nicht wirklich misst, was die meisten Menschen unter Intelligenz verstehen. Was er testet, ist die Verhaltensäquivalenz: Er soll herausfinden, ob ein bestimmtes Computerprogramm die Symptome des Intellekts aufweist, die möglicherweise nicht mit der wirklichen Intelligenz vergleichbar sind. Kannst du menschlich intelligent sein ohne dir darüber bewusst zu sein, dich selbst zu kennen, selbstbewusst zu sein, fähig zu sein, Selbstbewusstsein zu fühlen, Liebe zu erfahren, … lebendig zu sein?

Künstliche Intelligenz wird uns wahrscheinlich für viele weitere Jahrzehnte beschäftigen.

Weiterführende Literatur

Artificial intelligence: the very idea von dem Philosophen John Haugeland ist ein äußerst lesenswertes Buch über die Debatte betreffend künstliche Intelligenz, und ist die Quelle einiger der Illustrationen in dieser Aktivität (insbesondere der SHRDLU-Gespräche und der Diskussion darüber).

Der ursprüngliche Turing-Test wurde in einem Artikel mit dem Titel “Computing Machinery and Intelligence” von Alan Turing beschrieben, der 1950 in der philosophischen Zeitschrift Mind erschien und in dem von Feigenbaum und Feldman herausgegebenen Buch Computers and thought nachgedruckt wurde. Der Artikel enthielt die ersten beiden Gespräche.

Das Psychotherapeutenprogramm wurde in “ELIZA - A computer program for the study of natural language communication between man and machine “ von J. Weizenbaum beschrieben, das 1966 in der Computerzeitschrift Communications of the Association for Computing Machinery veröffentlicht wurde.

Das Roboterprogramm ‘blocks-world’ wird in der Dissertation von Terry Winograd beschrieben, die als Buch mit dem Titel Understanding natural language (Academic Press, New York, 1972) veröffentlicht wurde. Das Programm, das die Geschichte von Truman und Horace hervorgebracht hat, ist in “A planning mechanism for generating story text” von Tony Smith und Ian Witten beschrieben, das 1990 in den Proceedings of the 10th International Conference on Computing and the Humanities veröffentlicht

wurde.

Übungen und Materialien

- Eine Kopie des Arbeitsblatts Turing-Testfragen, die jedes Schulkind sehen kann (entweder eine für jedes Schülerpaar oder eine Kopie auf einem Projektor/Overhead-Projektor darstellen) und

- eine Kopie des Arbeitsblatts Turing-Test Antworten.